automatischer vorhang

felix schwenzel, , in artikel

einkäufe bei aliexpress, also direkt in china, sind eigentlich gar nicht aufregend. dieses mal war ich aber ziemlich aufgeregt. ich habe zum ersten mal etwas bestellt was teurer als 15 euro war, nämlich einen gardinenmotor. ich kann mich zwar nicht erinnern, jemals mit einer aliexpress-bestellung oder lieferung unzufrieden gewesen sein, aber diese bestellung hatte das potenzial dass einiges schief hätte laufen können, hat die laufschiene die richtge länge? funktioniert der motor mit 230 volt? kommt es heile an, ist es zu laut, kommt es durch den zoll?

um es vorwegzunehmen; die aufregung war unnötig, die lieferung hat wunderbar geklappt, der motor funktioniert wie erwartet, die schiene passt, alles liess sich an einem abend montieren.

hier erzähle ich im detail, wie ich die schiene bestellt habe, warum ich jetzt eine eori-nummer habe und wie sich der neue vorhang in meine haussteuerung einbinden liess.

die auswahl bei aliexpress an motorisierten gardinen ist riesig. bei amazon findet man auch ein paar angebote und ein paar deutschsprachige angebote habe ich auch gefunden. hier rangierten die preise für 3,50 meter länge von 480 bis 1100 euro, bei aliexpress war der preisbereich zwischen 120 und 300 euro. die motoren von dooya machten einen guten eindruck und schienen ein etabliertes produkt zu sein, das auch in europa unter verschiedenen markennamen (gowe, somfy) verkauft wird. der dt52e-motor schien mir die richtigen features zu haben, einen 433 MHZ funkempfänger, autokalibrierung und ein „light touch“ feature, mit dem man den vorhang durch leichten zug öffnen oder schliessen kann.

ich entschied mich am ende für dieses angebot, bei dem der preis für 3,50 meter länge allerdings nicht ganz klar war. also bat ich den händler per chat um ein angebot. das angebot was mir zhiwei ren machte hörte sich gut an:

Hello

friend

Your package includes a 3.49-meter curtain track, a DT52E curtain track motor for $ 155 USD to ship your package via Hong Kong Federation IE

ungefähr 130 euro, inklusive versand fand ich super. für die bezahlung schickte mir der händler einen anderen link, wo das produkt mit versand etwas teurer war, ich solle aber dort bestellen und dann die zahlung zurückhalten. nachdem ich dem händler die bestellnummer durchgab, senkte er den preis auf 155 dollar und ich bezahlte.

ein paar stunden später war ich dann fast wieder so weit, die bestellung zu canceln, der händler wollte eine eori-nummer von mir haben. eine kurz-recherche im netz ergab, das ist eine internationale zoll-nummer, mit der importeure die zollabfertigung vereinfachen können. das netz und die zoll-FAQs sagten, dass privatpersonen die eigentlich nicht benötigten. der händler meinte aber, dass er den versand ohne diese nummer nicht einleiten könne. nach einer eori-nummer hatte mich bisher noch nie ein aliexpress-händler gefragt, also musste ich mich wohl ins behörden-deutsch einlesen. tatsächlich war das aber relativ einfach und auch für privatpersonen möglich. der zoll erklärt:

Als förmlicher Antrag ist der Internetbeteiligtenantrag (IBA) oder das Formular 0870 "Beteiligte - Stammdaten - EORI-Nummer" zu verwenden. Dieser Antrag ist rechtsverbindlich zu unterschreiben und mit den erforderlichen Unterlagen per E-Mail (als PDF-Dokument), schriftlich oder per Fax der GZD - DO Dresden - Stammdatenmanagement zu übersenden.

auf deutsch heisst das alle pflichtfelder dieses formulars auszufüllen und den unterschriebenen ausdruck an den zoll zu faxen. das habe ich gemacht und bekam 5 tage später tatsächlich einen brief (per post) vom zoll mit meiner eori-nummer.

nachdem ich dem aliexpress-händler die eori-nummer schickte, konnte der die lieferung mit fedex klarmachen („Hong Kong Federation IE“ ist fedex, wusste ich auch nicht). das war insofern toll, weil ich jetzt die erste aliexpress-bestellung hatte, bei der ich den exakten verlauf des pakets verfolgen konnte. nach zwischenstops in hong-kong, neu dehli, dubai und paris, lag das paket dann ein wochenende im kölner luftfrachtflughafen und kam am montag zu mir ins büro.

ich schwör, es ist eine #gardinenstange. aus china. pic.twitter.com/4GE7xingAf

durch die zollabfertigung kam es ohne zollgebühren, weil der händler den warenwert (ungefragt) mit 30 euro angegeben hatte.

* * *

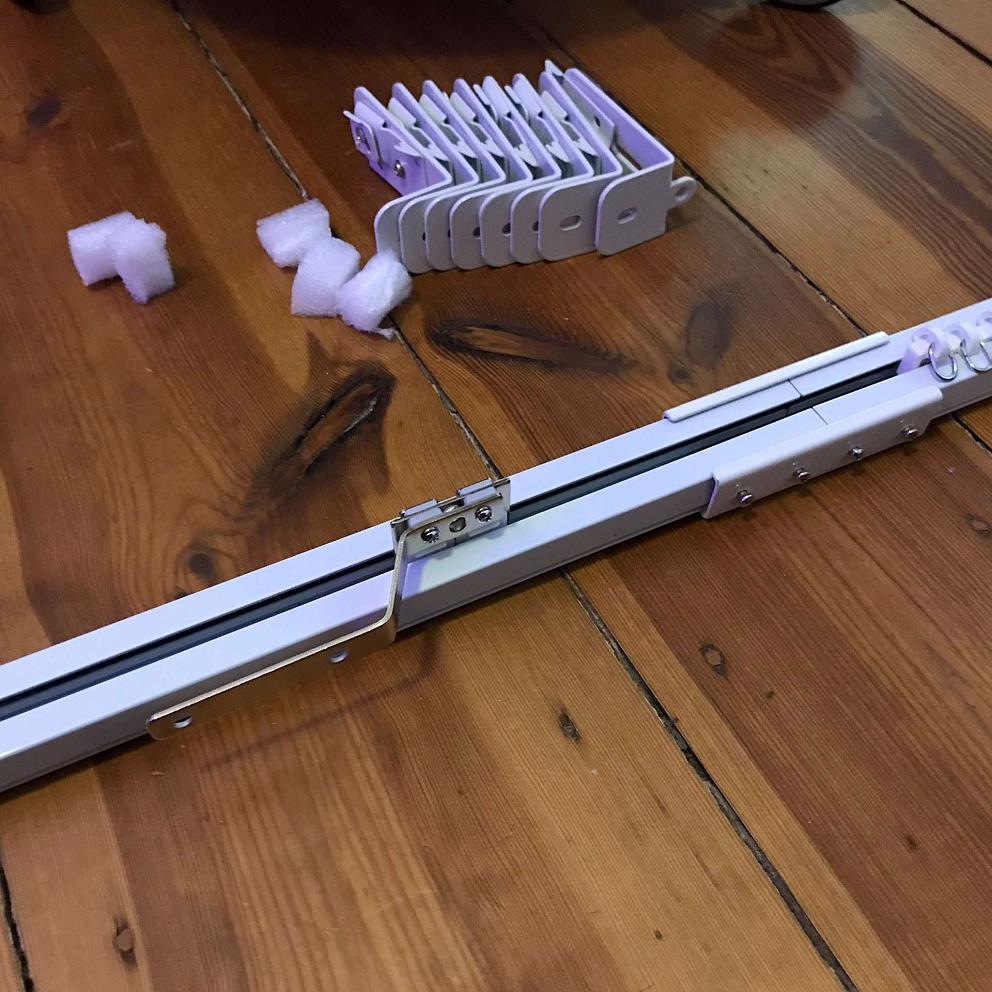

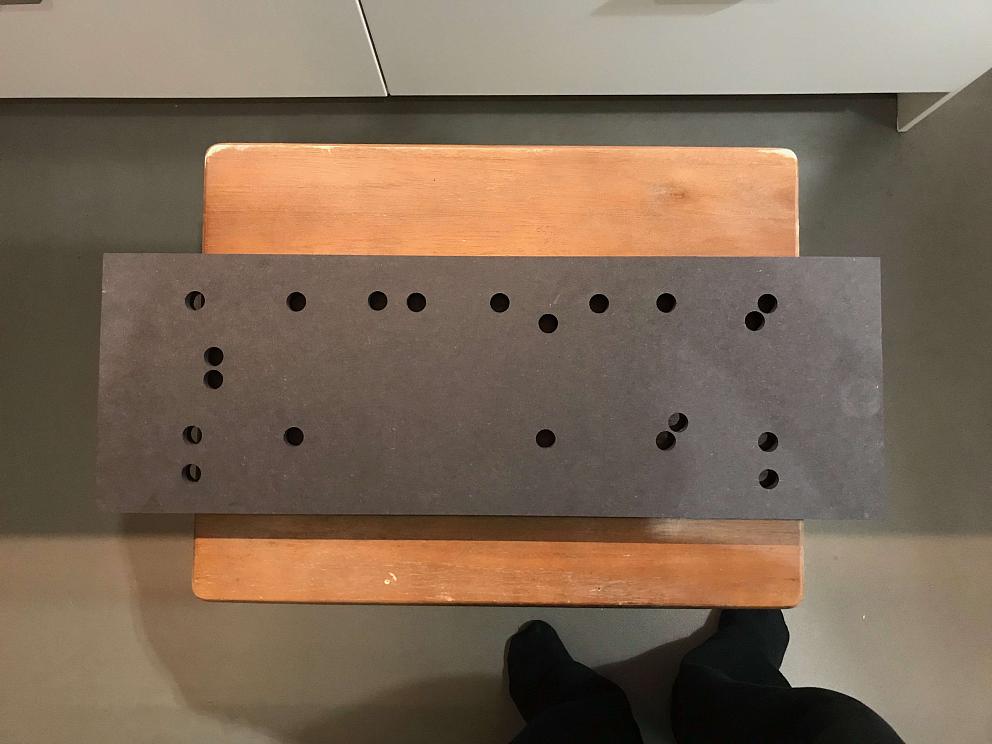

die gardinenschiene war vormontiert, allerdings für den transport in 1 meter lange stücke zerschnitten. mit ein paar montageplatten liess sich die schiene wieder zusammensetzen.

der transportgurt war auf die richtige länge vorgeschnitten, die rollen waren an der richtigen stelle, ich musste nur noch den zweiten transportwagen mit ein paar schrauben und halteplatten fixieren. und auch die länge der schiene war genauso wie bestellt und passte zwischen die wände. puh. der rest der montage war dann klassische wandmontage: anzeichnen, bohren dübeln, schrauben. nach ein paar stunden hing die stange.

der motor kam leider ohne fernbedienung. aber der witz mit dem vorhang, wie mit allen anderen haushaltsgeräten, ist ja nicht, dass er fernbedienbar ist, sondern dass ich ihn automatisieren kann, bzw. irgendwie in meine heimsteuerungszentrale homeassistant bekomme. dort kann ich regeln für den vorhang definieren, die dann, je nach komplkexität, auch ansatzweise intelligent wirken. zum beispiel öffnen und schliessen nach tageslichtbedingungen, wenn niemand da ist, bzw. keine gäste oder das kind nicht zu besuch ist. oder die überbrückung vom homeassistant in die home-app von apple, damit ich, beispielsweise, auf dem klo sitzend meiner uhr sagen kann: „vorhang schliessen“.

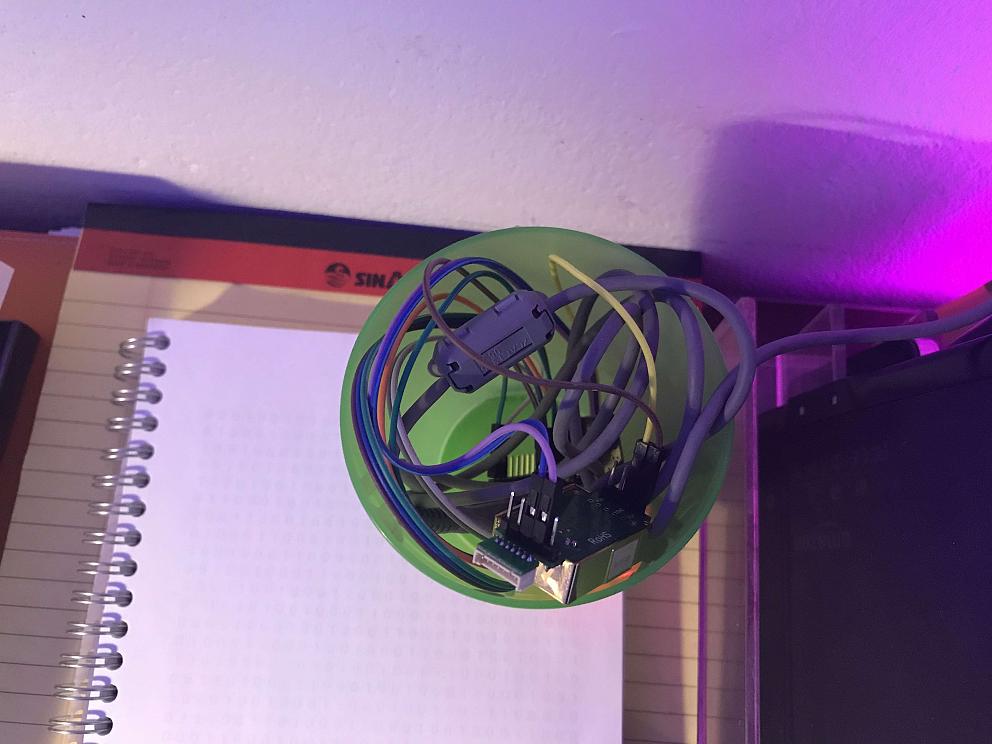

jedenfalls war die steuerung des motors dank meines in homeassistant angebundenen 433 MHZ senders/empfängers kein problem. in diesem diskussionsstrang hatte ich mich bereits vorab eingelesen und auch die rfxtrx-anleitung verliert worte dazu. einfach einen code ausdenken, motor darauf trainieren, fertig. ein bisschen komplizierter wird’s nur deshalb, weil man zum trainieren den rfxtrx eigenen manager, ein windows-programm wie aus den 80ern, nutzen muss. aber dank virtual box geht das heutzutage ja auch mal eben.

die einbindung in homeassistant und homebridge ist eigentlich trivial, aber dann im detail doch nochmal ein bisschen kompliziert. der vorhang versteht nur drei befehle, öffnen, schliessen, stoppen. feedback zur position liefert er nicht, auch nicht wenn er manuell bewegt wird (man kann den vorhang auch durch leichtes zerren am vorhang öffnen oder schliessen; das startet den motor). die home-app von apple möchte aber einen rückgabewert des öffnungszustands haben. weil der vorhang sich mit 20 cm pro sekunde bewegt, lässt sich die position aber leicht ausrechnen und als fake-sensor einbinden.

* * *

ich bin sehr angetan von diesem motorisierten vorhang. die beifahrerin nur so mittel, sie findet die schiene eher hässlich. und die öffnung zu den seiten unpraktisch, weil ein kleiner teil des rechten, geöffneten vorhangs noch das fenster verdeckt. da werde ich irgendwann nochmal eine baustelle aufmachen müssen, die schiene mit einer blende verstecken, in der sich eventuell auch eine beleuchtung untzerbringen liesse und die öffnungsgeometrie von links/recht zur mitte ändern in links/mitte nach rechts. die mechanik der schiene müsste das hergeben, ich glaube das lässt sich umbauen.

die grundidee, nicht mehr morgens und abends an zwei tüchern die vor dem fenster hängen selbst ziehen zu müssen, ist grossartig. dass sich die vorhänge zur strassenseite hin auch bei abwesenheit öffnen und schliessen lassen ist balsam auf die leicht paranoide seele der beifahrerin und tut den pflanzen im kinderzimmer auch gut. das handling des vorhangs auch mit konsvervativen methoden (zerren) entspricht meiner lieblingsphilosophie beim heimautomatisieren: optimalerweise sollte alles so funktionieren wie vorher, plus passgenaue automatisierung wo es sinnvoll ist — und bei internet- oder stromausfall sollte möglichst viel weiter funktionieren.

der chinesische händler war zwar der meinung, dass zu meiner bestellung keine fernbedienung gehörte, entscheid sich aber, nachdem ich ihn auf unsere chatprotokolle hinwies, in denen ich den eindruck bekommen hatte dass sie dabei sei, für eine nachlieferung. ich kann den händler deshalb vorbehaltslos weiterempfehlen (das ist ein link auf seinen shop), das handling der bestellung, der lieferung und der konfektionierung war tadellos. dass der händler eine eori-nummer haben wollte hat mich kurz echauffiert, aber es zeigte sich, dass es sich lohnte, den die lieferung per fedex war die bisher schnellste und lückenlosest dokumentierte bestellung die ich jemals in china getätigt habe.

die mechanik dser schiene und des antriebs ist ziemlich ausgefeilt und flexibel und soweit ich sehe, kann man die laufrichtungen auch selbst anpassen. der motor ist relativ leise und arbeitet bisher tadellos.nur eins hat mich bei aller ausgefeiltheit der mechanik gewundert: hängt man den vorhang einfach an die laufrollen und lässt ihn motorisiert schliessen, zieht der motor die vorhänge ohne raffung, ohne faltenwurf zu.

die vorhänge hängen dann wie tücher vorm fenster. das liess sich mit schnürchen, mit denen ich die laufrollen in geringerem abstand zusammenband beseitigen, irritierte mich aber angesichts der ausgefeiltheit der restlichen mechanik.

eventuell lässt sich das auch durch gechicktere befestigung des stoffs beseitigen, aber ins fachgebiet dekoration wollte ich mich nicht auch noch einarbeiten. ich bin auch so sehr, sehr zufrieden.