MEO statt SEO (manic engine optimisation)

ich optimiere ja gerne an meinem kirby rum.

ich weiss gar nicht genau warum, weil eigentlich ist es mir egal sachen richtig zu machen und wichtiger dinge so zu machen, wie sie mir gefallen. andererseits gibt es oft überschneidungen zwischen richtig und gefällt mir.

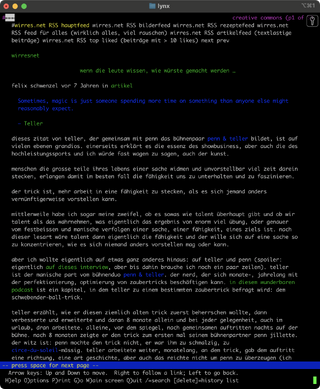

so gefällt es mir, wenn meine webseite in allen browsern und readern, die ich selbst gerne benutzte, gut aussieht. responsive design, also dass sich die webseite an die bildschirmgrösse anpasst, ist ja mittlerweile fast ein no-brainer. gelegentlich schaue ich mir meine website auch mit lynx an, einem textbasierten kommandozeilen-browser. damit sieht man dinge, die normale browser nicht zeigen, die aber trotzdem von manchen menschen oder maschinen, die die website besuchen, so gesehen werden kann. genauso gerne rufe ich meine webseite gelegentlich mit deaktiviertem css auf. beide, lynx und kein-css zeigen potenzielle probleme, die ich wegoptimieren oder aufschieben kann.

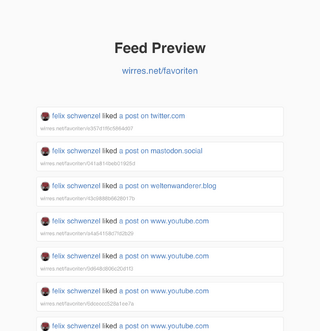

weil ich selbst gerne und viele webseiten per RSS lese, prüfe ich auch regelmässig wie meine seite in RSS aussieht — und wenn mir was auffällt oder mich stört, optimiere ich es weg. neben diversen RSS-feeds, biete ich diese webseite auch sozusagen als html-feed an. das geht, weil ich das HTML mit microformaten (mf2) auszeichne. damit lässt sich diese seite als json parsen (beispiel) und sogar als html-feed abonnieren (vorschau)

all diese ansichten, in lynx, ohne css, als geparste oder gerenderte mf2-microformate oder als RSS-feed, sind ansichten dieser website, wie sie auch maschinen sehen, suchmaschinen- oder KI-crawler, der rivva-bot oder andere aggregatoren. auch screenreader sehen die website eher in diesen minimalversionen, weshalb ich auch ein interesse daran habe, dass wirres.net in diesen ansichten ganz okay aussieht, bzw. mir gefällt.

das schöne an den eingebauten mf2-microformaten ist auch, dass man mit geeigneten readern auch meinen favoriten- oder bookmarks-strom abonnieren könnte, obwohl ich dafür noch kein RSS gebaut habe.

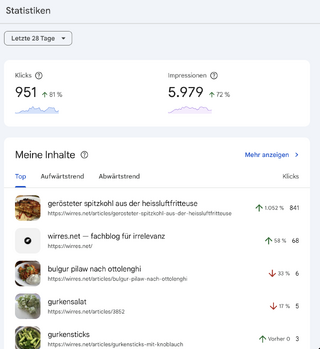

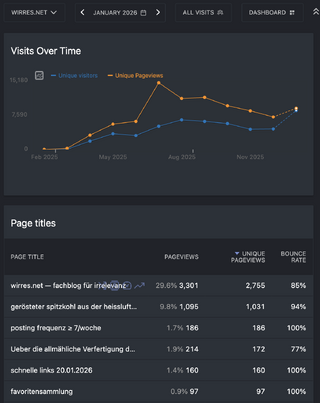

ich bemühe mich natürlich auch um gute maschinenlesbarkeit damit sich meine webseite gut mit google versteht. nach meiner blogpause und ein paar monaten offline-zeit wegen technischer probleme, verlor ich alle sympathien die mir google vormals gewährt hatte. noch nicht mal eine suche nach meinem namen zeigte meine heimstätte im netz (wirres.net) mehr auf den ersten 10 suchergebnisseiten an. nachdem ich es hier wieder schön für google und andere maschinen gemacht habe, schickt mir google auch gelegentlich wieder besucher vorbei. derzeit zwar nur für eine seite (erfreulich und erschütternd), aber dafür im januar so um die 1000.

irgendwann vor ein paar monaten gefiel mir die idee, dass ich bilder hier so unter einer cc lizenz veröffentlichen könnte, so dass suchmaschinen sie auch mit dieser lizenz erkennen. bei flickr klappt das super, wenn man dort für seine fotos eine cc-lizenz gewählt hat. weil ich das auch wollte, aber natürlich auch weil ich die idee der reibungslosen maschinenlesbarkeit gut finde, habe ich angefangen für alle artikel json-ld mit auszuliefern. damit liefere ich zwar auch nicht viel mehr metadaten als mit den microformaten aus, aber unter anderem kann man eben auch bilder explizit mit lizenzen versehen.

das klappt einerseit auch ganz gut, andererseits vergisst google einmal indexierten und erkannten lizenzen aber auch immer wieder. irgendwie schaffe ich es nicht, mit mehr als 50 bilder von dieser website mit cc lizenz in den suchergebnisseiten unterzubringen.

was mit json-ld allerdings super klappt ist die maschinenlesbatre auszeichnung von rezepten. so ausgezeichnete rezepte nimmt google mit kusshand und rezepte die im karussel oben in den suchergebnissen angezeigt werden sind auch der grund, warum google mir im moment so viele besucher schickt. zum ersten mal mit maschinenlesbaren rezeptdaten experimentiert hab ich vor 14 jahren. mittlerweile klappt das wirklich gut.

was ich aber eigentlich sagen will: diese ganzen optimierungen, die ich auch gerne als experimente ansehe um suchmaschinen- und technik-gedöns besser zu verstehen, haben vor allem den effekt, dass ich kleine, subtile, aber auch grobe fehler aud wirres.net finde, die ich sonst nie gefunden hätte oder die mir egal gewesen wären.

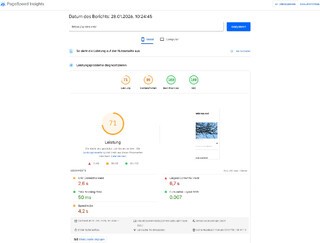

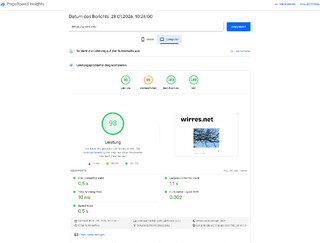

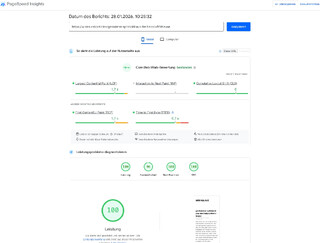

vor ein paar monaten habe ich sehr viel energie darein gesteckt in den PageSpeed Insights gute punktzahlen zu bekommen. dabei habe ich viele anpassungen am server vorgenommen, die html-struktur, lazy und eager-loading und die bildgrössen optimiert. mit der startseite ist google nicht immer 100% zufrieden, aber die einzelseiten schrammen in der regel an den 100%.

gleichzeitig habe die speed-optimierungen wieder zu fehlern an anderen ecken geführt, die ich dann nach und nach wieder wegoptimiere. so ergibt sich im prinzip ein manischer kreislauf von immer neuen optimierungen. mach ich aber gerne, vor allem weil: ist ja alles meins hier.

tools die ich gerne zum rumoptimieren nutze: