abmahnung, aus dem maschinenraum

als ich vor 23 jahren anfing mit einem content managment system ins internet zu schreiben, war ich in vielerlei hinsicht ein bisschen naiv. auch was die nutzung von bildern angeht. wenn schlechte witze (arnold schwarzegger hat schrankfarbene haare) die nutzung eines bildes erforderten, suchte ich mir ein bild und benutzte es. 2002 wurden urheberrechtsverstösse eher selten geahndet und google war gerade mal 4 jahre alt.

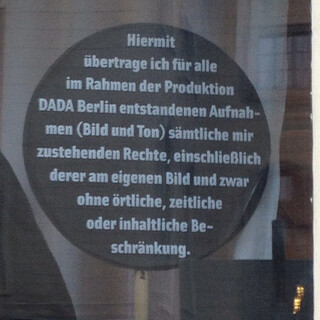

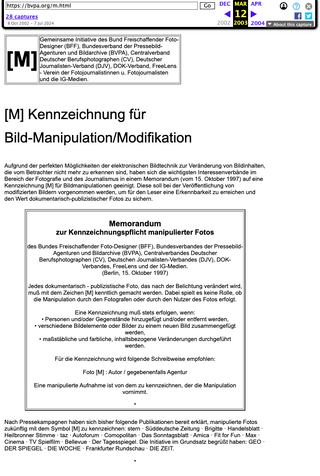

spätestens zu zeiten von marions kochbuch (die älteren werden sich erinnern) fing ich an mein archiv für suchmaschinen zu verrammeln. bei artikeln die älter waren als 5 jahre verbot ich die suchmaschinen indexierung. das hat soweit gut geklapt. in den > 20 jahren in denen ich ins internet schrieb habe ich zwar die eine oder andere abmahnung bekommen, aber nie wegen urheberrechtverstössen. bis heute. ein foto von arnold schwarzenegger das seit 20 jahren im web rumlag, ausgeschlossen von suchmaschinen-indexierung und ungesehen von jeder menschenseele, wurde doch von irgendeinem rechteinhaber gefunden. die seite, auf der das bild laut anwaltsschreiben zu sehen gewesen sei, war von der suchmaschinenindexierung ausgeschlossen und damit im prinzip unsichtbar. ich weiss zwar, dass ethisch fragwürdige crawler sich nicht an robots.txt anweisungen halten, aber dass möglicherweise für die durchsetzung von urheberrechten auch solche anweisungen ignoriert werden, scheint neu zu sein.

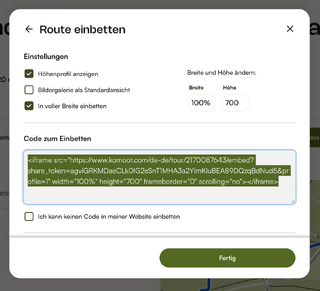

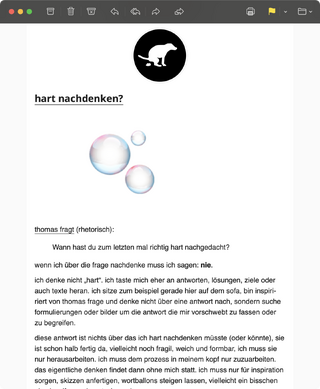

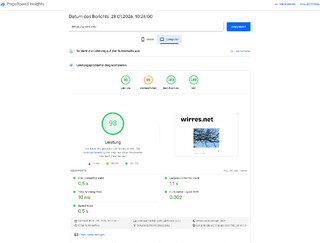

die 250 € habe ich überwiesen, das bild gelöscht und den artikel entfernt und gleichzeitig habe ich alle bilder von artikeln die älter als 2010 sind mit thumbhash bildern ersetzt. thumhashs sind „very compact representations of an image“, die gerade mal ein paar byte gross sind. die nutze ich schon länger fürs lazyloading, man bekommt die also zu sehen wenn man wirres.net mit einer sehr langsamen internetverbindung besucht. ansonsten sieht man die nur selten. hier eine beispielseite aus meinem archiv.

die riesenmaschine macht das schon lange so mit bildern, deren rechtelage ungeklärt ist: einfach weglassen.

aber nur wegen eines anwaltschreibens soll mein archiv nicht weniger bunt sein. deshalb finde ich meine lösung, bilder erstmal pauschal auf wenige bunte byte zu reduzieren sehr schön. und artikel mit bildern, über deren rechte ich mir im klaren bin (zum beispiel weil ich die bilder selbst aufgenommen habe), kann ich von der thumbhashisierung ausnehmen, aber das ist ein manueller vorgang.

so hat die abmahnung auch was gutes: ein schönes neues feature, von dem ich aus dem maschinenraum berichten kann.

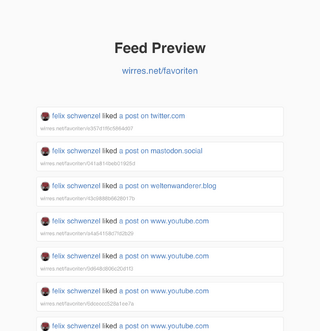

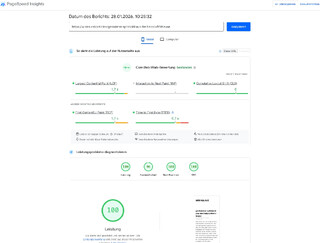

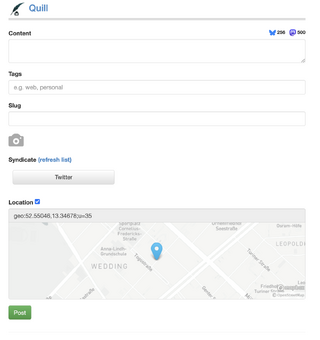

es gibt auch sonst einiges neues aus dem maschinenraum. zum beispiel neue feeds für den river, die favoriten, bookmarks oder was ich gesehen habe (alle feeds sind autodiscoverable oder hier aufgelistet). unter /alles sieht man jetzt auch wieder wirklich alles, ebenso im alles-feed. auch im archiv sieht man beiträge, favs, bookmarks und gesehenes jetzt einzeln aufgeschlüsselt — oder eben als alles.

beispiel für gestern: alles, beiträge, favs, bookmarks, gesehen.

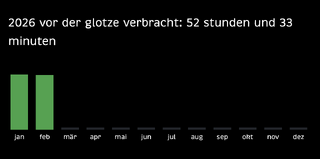

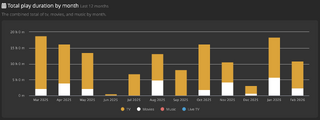

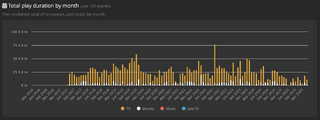

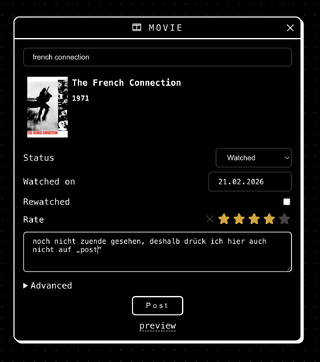

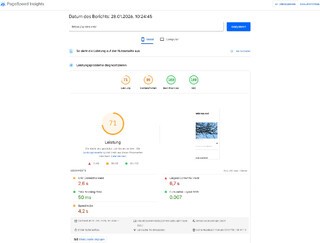

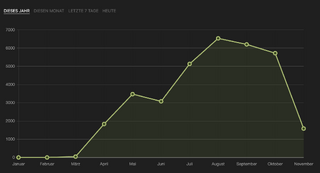

das logbuch meines medienkonsums, das ich dieses jahr führen möchte habe ich um die youtube sehzeiten erweitert. derzeit steht mein medienkonsum bei ca. 70 stunden pro monat die ich vor der glotze verbringe. ich bin mal gespannt wie sich das oder ob sich das über das jahr verändert.

und apropos gewohnheiten, die man offenbar mit zunehmensdem alter liebgewinnt, mal schauen ob mir entwicklung der gewohnheit gelingt, diesen baum ein jahr lang jeden tag zu fotografieren.