baustellen ohne ende

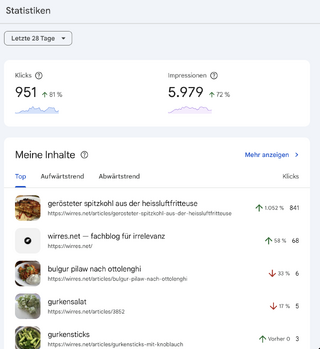

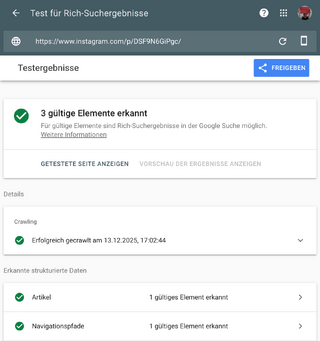

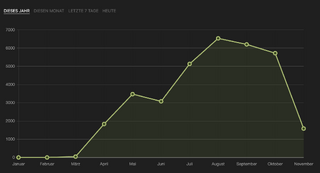

nachem ich mir gestern eine möglichkeit geschaffen spaziergänge als .gpx-dateien hochzuladen und darzustellen, habe ich mal geschaut, ob ich sowas schon früher versucht habe. dabei habe ich diesen alten artikel von 2015 gefunden, der zwar eine gpx-datei erwähnt, aber nicht beinhaltet. stattdessen fiel mir auf das der artikel ein paar fehler enthielt. die videos funktionieren nicht, asides werden mittig, statt am rand angezeigt und die fotos hatten noch keine expliziten lizenz-informationen. meine imports vom alten blog in kirby funktionierten eigentlich ganz gut, aber bei einzelen details klemmte es dann doch immer wieder, auch weil ich zum zeitpunkt des ex- und imports in kirby noch nicht alle features abgebildet hatte.

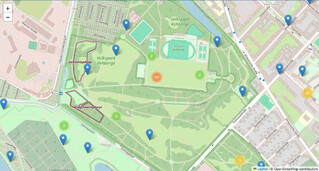

beim reparieren des artikels, fiel mir dann noch auf, dass die importierten fotos tatsächlich noch ihre exif-daten in sich trugen, also lud ich die auch nach. mit den exif-infos war es kirby dann möglich automatisch eine karte der foto-orte zu generieren, die sich dann erfreulicherweise fast so aussah wie die karte, die ich vor 10 jahren aus einer .gpx-datei generiert hatte, damals boch bei einem externen dienst, der längst das zeitliche gesegnet hat.

das freute mich sehr, denn so war der alte artikel nach der reparatur besser als vorher.

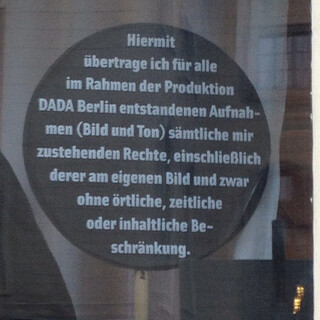

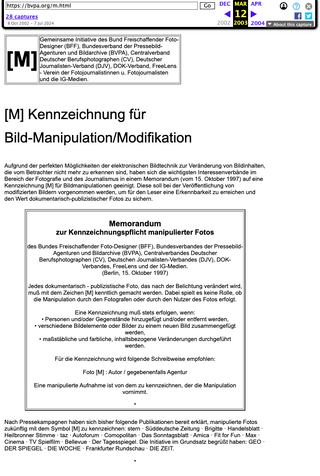

das dinge im netz kaputtgehen ist unumgänglich. auch die archive.org-version des alten artikels ist nicht mehr (oder war es nie) in ordnung. deshalb, lesson learned, ist es wirklich sinnvoll alle daten, originale bei sich zu behalten, man weiss ja nie wozu sie gut sein werden. und es ist immer sinnvoll dinge ohne harte externe abhängigkeiten zu bauen. das heisst nicht, dass man nicht auch mal externe dienste nutzen soll oder inhalte dorthin aggregieren oder syndizieren sollte, sondern eben, dass man es im ernstfall eben auch selbst machen kann, ohne abhängig von einem dritten zu sein.

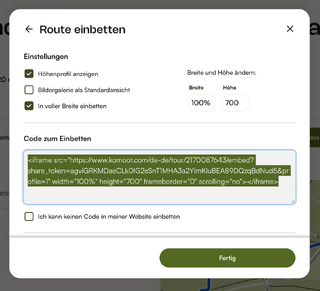

deshalb freue ich mich auch so einen weg gefunden zu haben eine gpx-datei hier lokal darzustellen. mit komoot könnte ich sowas per iframe einbetten, aber dann habe ich einerseits eine abhängigkeit und andererseits tracking-codes eines dritten auf meinen seiten.

andererseits spricht nichts dagegegen touren, wie die wanderung um den „de meinweg“ weiterhin mit komoot aufzuzeichnen und dort zu teilen, so lange ich sie auch als gpx exportieren kann. genau diesen export hab ich jetzt im alten artikel über die wanderung nachgepflegt. wenn dann in 30 jahren komoot nicht mehr ist, hab ich immer noch alle wesentlichen daten bei mir.

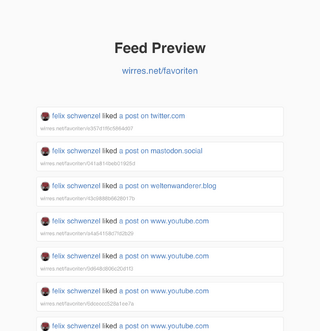

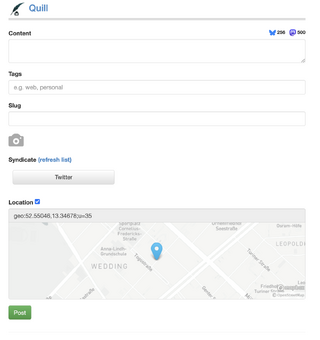

seit ich angefangen habe bookmarks (und likes) bei mir zu sammeln (bookmarks, likes, replies, alles zusammen, wirklich alles), statt in pinboard, sende ich mit diesen lese- oder like-notizen auch webmentions an die betreffenden seiten. die meisten ignorieren das aus technischen gründen (weil sie keine webmentions unterstützen), aber manche nehmen die benachrichtigung entgegen. eay.cc zum beispiel, da wurden meine bookmark-webmentions dann aber komisch dargestellt, also hat er das repariert und spass dabei gehabt.

oder gestern habe ich crowdersoup.com einen kommentar geschickt. der wurde angenommen aber jetzt muss das layout offenbar repariert werden. bei beiden war ich offenbar der erste, der sowas geschickt hat und ehrlichgesagt bin ich hier auch nicht auf alle webmention-arten vorbereitet, die mir potenziell geschickt werden können.

aber das ist eben teil des spass: build & repair as you go, probleme dann lösen, wenn sie daherkommen. oder anders gesagt: eine webseite ist eine baustelle die wirklich kein ende hat — und das ist auch gut so.

ich weiss gar nicht mehr wie ich crowdersoup.com entdeckt habe, aber ich vermute über indiewebnews. den beiträgen dort folge ich seit kurzem wieder intensiver und komme dadurch vermehrt auf webseiten die sich mit den technologien des indiewebs auseinandersetzen — oder genauer: damit ringen. der gleichzeitige vor- und nachteil der indieweb-idee ist, dass es kaum fertige lösungen gibt und man sich eigentlich alles selbst zusammenbaut. das ist ein segen und ein fluch und ich verfluche die komplexität dieses indiwweb-gedöns auch regelmässig, um dann doch immer wieder einen neuen versuch zu starten.

diese definition von marty mcguire umschreibt die idee des indieweb ganz gut, vor allem was es ist und eben nicht ist:

indieweb.org is not a presciption or a cookbook or an exercise plan. It doesn’t tell you how to “be IndieWeb”. It’s a collective memory of experiments, some successful and some not, from a group of experimenters that has changed greatly over time.

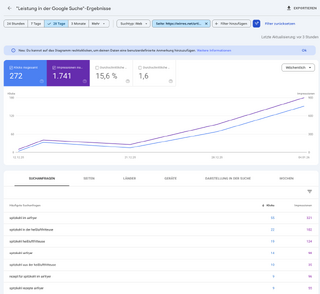

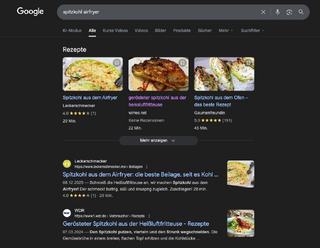

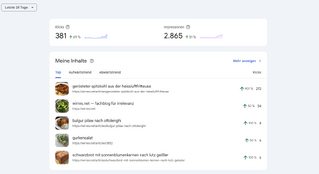

was mir aber, abgesehen von den philosophischen fragen, heute auffiel: die idee des indiewebnews-aggregators kann man eigentlich weiterspinnen. indiewebnews ist ein aggregator in dem man sich selbst einträgt, einfach indem man indiewebnews verlinkt und dann ein webmention an indiewebnews sendet (anleitung auf deutsch bei news.indieweb.org/de). dieses vorgehen macht die seite nicht 100% spam-resistent, aber mit ein bisschen moderation könnte man daraus eigentlich sehr schöne aggregatoren zu allen möglichen themen bauen. wie gesagt, seit ich den englischen kanal der indiewebnews näher verfolge, habe ich viele neue, interessante webseiten/blogs gefunden die interessante sachen schreiben oder bauen oder zeigen. vielleicht könnte man so blog-themen-hubs bauen. mir fehlt leider die strukturierte phantasie um so ein konzept zu verfeinern, aber die discoverability und sichtbarkeit von blogs und webseiten zu verbessern ist ja ein erstrebenswertes ziel.